Apple va scanner les iPhone à la recherche de contenus pédo-pornographiques

Apple vient d’annoncer le déploiement de trois nouvelles fonctionnalités destinées à la protection des enfants, dans le but de prévenir toute sorte d’abus ou d’attaques de prédateurs sexuels. Une technologie de détection d’images pédopornographiques va, entre autres, scanner les images des iPhone.

Dans un communiqué technique, Apple vient d’annoncer le déploiement de trois nouvelles fonctionnalités destinées à la protection des enfants, dans le but de prévenir toute sorte d’abus ou d’attaques de prédateurs sexuels. Ces mesures concernent iOS 15, iPadOS 15, et macOS Monterey. Des systèmes d’exploitation qui débarqueront d’ici à l’automne. L’une d’entre elles, qui reste extrêmement controversée à cet instant, permet à Apple de scanner la bibliothèque Photos des iPhone, à la recherche d’images pédopornographiques. Un procédé que Google utilise depuis 2008 déjà.

Trois mesures frontales pour lutter contre la pédopornographie

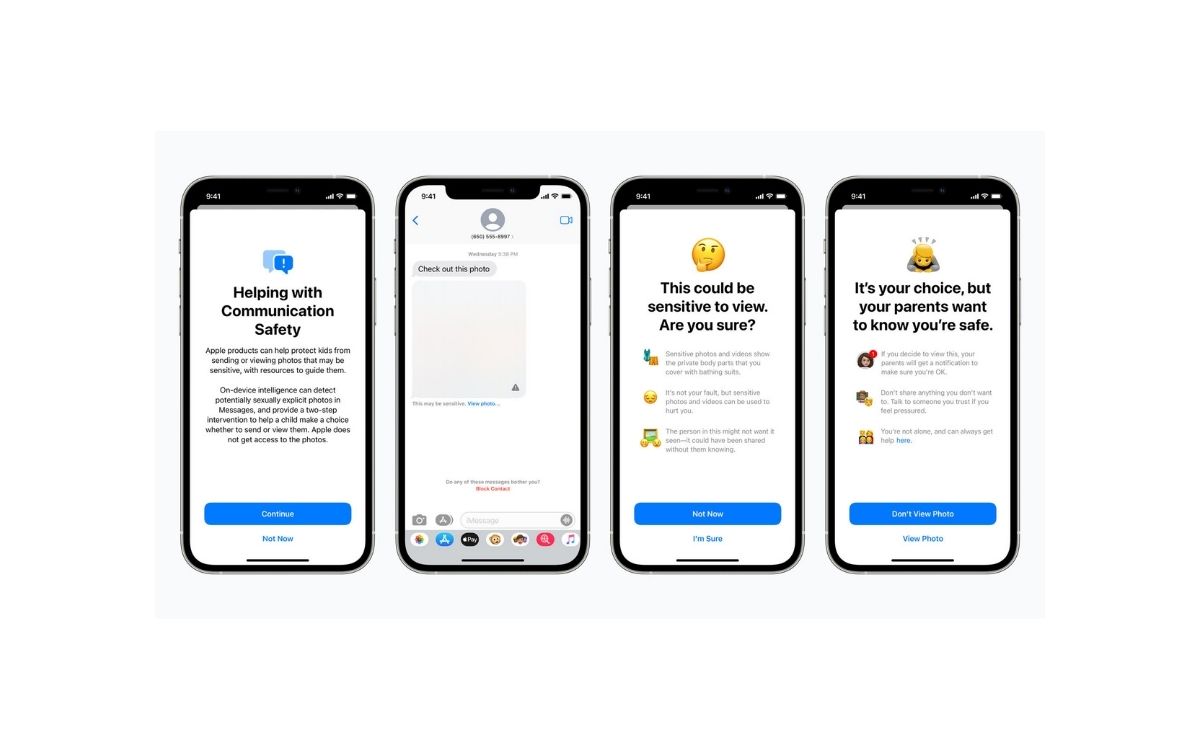

La première mesure concerne les comptes Apple configurés en partage familial. Sur ces appareils, l’application Messages préviendra les jeunes utilisateurs que tel ou tel contenu reçu est potentiellement sensible. Des images pédopornographiques envoyées par des prédateurs sexuels, par exemple. Ces images seront floutées et une alerte sera envoyée sur l’appareil de l’enfant. S’il décide de la regarder quand même, les parents seront immédiatement notifiés. Apple indique n’avoir aucun accès à ces messages.

La deuxième mesure est la technologie de détection d’images pédophiles, celle qui fait du bruit actuellement, qu’Apple nomme NeuralHash. Elle concerne iOS et iPadOS, avec un compte iCloud Photos actif uniquement. Si l’appareil détecte une image de la bibliothèque Photos relative à des cas d’abus sexuels sur des enfants, Apple sera en mesure d’alerter le National Center for Missing and Exploited Children (NCMEC), ainsi que d’autres groupes de protection de l’enfance.

Comment ça marche ? Avant qu’une image n’atterrisse dans la bibliothèque iCloud, NeuralHash l’analyse et la convertit en une suite de chiffres. Puis, avant d’être téléversée dans la bibliothèque iCloud, NeuralHash compare cette suite de chiffres avec ceux d’une base de données du NCMEC et d’autres groupes relatifs à la protection de l’enfance.

Si une image de l’utilisateur correspond avec une image pédopornographique enregistrée — si les chiffres correspondent donc —, Apple procédera à une analyse manuelle, avant que le compte iCloud ne soit désactivé et qu’un rapport soit envoyé au NCMEC, qui prendra les mesures nécessaires.

Concernant le niveau de confidentialité, Apple garantit un niveau « extrêmement élevé » de vigilance et de correspondance afin que les comptes ne soient pas signalés de manière incorrecte (comme avec les images de son propre enfant prenant un bain, par exemple). Apple précise qu’elle n’aura accès qu’à ces images — que — si une correspondance est établie, et pas à celles qui ne correspondent pas.

La troisième et dernière mesure proposera des liens permettant de remonter des cas d’exploitation sexuels de mineurs directement depuis les appareils Apple, au cas où l’utilisateur le demanderait.

L’usage d’une telle technique peut s’avérer surprenante de la part d’Apple, qui défend depuis toujours la vie privée de ses utilisateurs (voir récemment : sous iOS 14, les apps comme Facebook ne pourront plus vous traquer sans votre consentement). Cupertino affirme en revanche avoir conçu chacune de ces nouvelles fonctionnalités dans le but de garantir la confidentialité de tous, tout en luttant contre l’exploitation des enfants en ligne.

Ces mesures seront, pour l’instant, limitées aux États-Unis. Aucun mot sur leur déploiement en France pour le moment. Pour bien vous renseigner à ce sujet, n’hésitez pas à lire le site Internet déployé par Apple ainsi que la documentation technique qui détaille les procédés.